ニューラルネットワークの仕組みとPythonでの実装方法

ニューラルネットワークとは、人間の脳の神経細胞を模したコンピュータのプログラムです。ニューラルネットワークは、機械学習や人工知能の分野で広く使われており、画像認識や自然言語処理などのさまざまなタスクに応用されています。

この記事では、ニューラルネットワークの基本的な仕組みと、Pythonでニューラルネットワークを実装する方法について紹介します。

ニューラルネットワークの仕組み

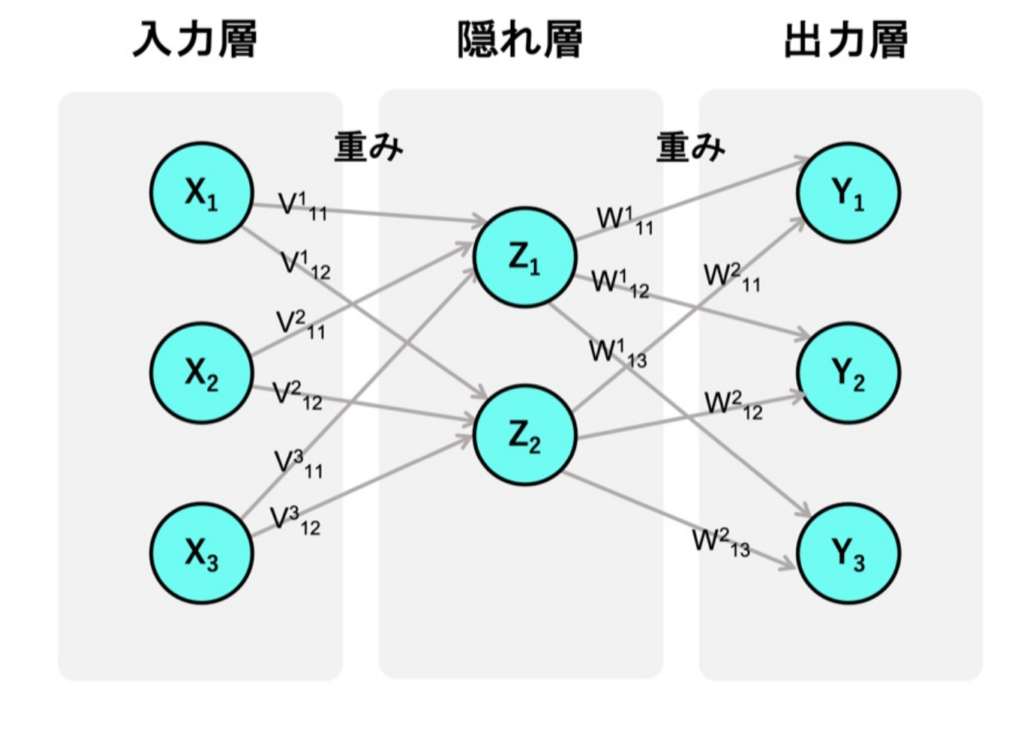

ニューラルネットワークは、入力層、隠れ層、出力層と呼ばれる3つの層から構成されます。入力層は、データを受け取る部分です。

隠れ層は、入力層から受け取ったデータを加工する部分です。出力層は、隠れ層から受け取ったデータを最終的な結果として出力する部分です。

各層は、複数のニューロンと呼ばれる単位に分かれており、各ニューロンは前の層のニューロンと重みと呼ばれる係数で結ばれています。

各ニューロンは、前の層から受け取ったデータに重みをかけて合計し、活性化関数と呼ばれる関数によって出力を決めます。活性化関数には、シグモイド関数やReLU関数などがあります。

ニューラルネットワークは、教師あり学習と呼ばれる方法で学習します。教師あり学習とは、正解のラベルが付いたデータを用いて、ニューラルネットワークの重みを調整することで、正しい出力を得られるようにする方法です。

ニューラルネットワークの学習には、誤差逆伝播法と呼ばれるアルゴリズムが使われます。

誤差逆伝播法とは、出力層から入力層に向かって、出力と正解の差(誤差)を計算し、その誤差に応じて重みを更新することで、ニューラルネットワークの精度を向上させるアルゴリズムです。

【初学者必見!】動画で学びたい人向け!深層学習を動画で学ぼう!初心者におすすめの動画コンテンツ3選はこちら

Pythonでニューラルネットワークを実装する

Pythonは、機械学習や人工知能の分野で広く使われているプログラミング言語です。Pythonには、ニューラルネットワークを簡単に実装できるライブラリが多数存在します。

代表的なライブラリには、TensorFlowやPyTorchなどがあります。ここでは、TensorFlowを使ってニューラルネットワークを実装する例を紹介します。

TensorFlowは、Googleが開発したオープンソースの機械学習ライブラリです。TensorFlowでは、ニューラルネットワークをグラフと呼ばれるデータ構造で表現します。

グラフは、ノードとエッジで構成されます。ノードは、ニューラルネットワークの層や演算を表します。エッジは、ノード間のデータの流れを表します。

TensorFlowでは、グラフを構築した後に、セッションと呼ばれるオブジェクトを作成して、グラフを実行します。

以下は、TensorFlowを使ってニューラルネットワークを実装するコードの例です。このコードでは、MNISTと呼ばれる手書き数字の画像データセットを用いて、ニューラルネットワークを学習させています。

ニューラルネットワークは、入力層が784個(28×28ピクセルの画像)、隠れ層が128個、出力層が10個(0から9までの数字)のニューロンから構成されています。

活性化関数は、隠れ層ではReLU関数、出力層ではソフトマックス関数を使っています。誤差関数は、交差エントロピー関数を使っています。最適化アルゴリズムは、勾配降下法を使っています。

# TensorFlowのインポート

import tensorflow as tf

# MNISTデータセットのインポート

from tensorflow.examples.tutorials.mnist import input_data

mnist = input_data.read_data_sets("MNIST_data/", one_hot=True)

# 入力データのプレースホルダ(入力層)

x = tf.placeholder(tf.float32, [None, 784])

# 重みとバイアスの変数(隠れ層と出力層)

W1 = tf.Variable(tf.random_normal([784, 128]))

b1 = tf.Variable(tf.random_normal([128]))

W2 = tf.Variable(tf.random_normal([128, 10]))

b2 = tf.Variable(tf.random_normal([10]))

# ニューラルネットワークの計算(隠れ層と出力層)

h1 = tf.nn.relu(tf.matmul(x, W1) + b1)

y = tf.nn.softmax(tf.matmul(h1, W2) + b2)

# 正解ラベルのプレースホルダ

y_ = tf.placeholder(tf.float32, [None, 10])

# 誤差関数(交差エントロピー)

cross_entropy = tf.reduce_mean(-tf.reduce_sum(y_ * tf.log(y), reduction_indices=[1]))

# 最適化アルゴリズム(勾配降下法)

train_step = tf.train.GradientDescentOptimizer(0.5).minimize(cross_entropy)

# セッションの作成

sess = tf.Session()

# 変数の初期化

sess.run(tf.global_variables_initializer())

# 学習の実行(1000回繰り返す)

for i in range(1000):

# バッチサイズが100のランダムなデータを取得

batch_xs, batch_ys = mnist.train.next_batch(100)

# 学習ステップを実行

sess.run(train_step, feed_dict={x: batch_xs, y_: batch_ys})

# 正解率の計算

correct_prediction = tf.equal(tf.argmax(y,1), tf.argmax(y_,1))

accuracy = tf.reduce_mean(tf.cast(correct_prediction, tf.float32))

# テストデータで正解率を表示

print(sess.run(accuracy, feed_dict={x: mnist.test.images, y_: mnist.test.labels}))

# セッションの終了

sess.close()

このコードの実行結果は、MNISTデータセットで約95%の正解率を達成するというものです。これは、ニューラルネットワークが手書き数字の画像を高い精度で認識できることを示しています。

しかし、このコードはまだ改善の余地があります。例えば、以下の点を工夫することで、ニューラルネットワークの性能を向上させることができます。

- 隠れ層の数やニューロンの数を変えてみる

- 活性化関数や最適化アルゴリズムを変えてみる

- 学習率やバッチサイズなどのハイパーパラメータを調整する

- データの前処理や正規化を行う

- ドロップアウトやバッチ正規化などのテクニックを使う

以上のように、Pythonでニューラルネットワークを実装する方法について紹介しました。ニューラルネットワークは、様々な問題に対応できる強力なツールですが、その仕組みやパラメータについて理解することが重要です。PythonとTensorFlowを使って、自分でニューラルネットワークを作ってみましょう。

コメント