自然言語処理(NLP)入門:言語モデルとは何か?代表的なモデルを紹介

自然言語処理(NLP)とは、人間が日常で使う言語をコンピュータに理解させる技術のことです。NLPはAI(人工知能)の一分野であり、様々な応用があります。例えば、検索エンジンや翻訳サービス、音声認識やチャットボットなどがNLPの技術を利用しています。

言語モデルとは

NLPの技術の中核にあるのが、言語モデルと呼ばれるものです。言語モデルとは、単語や文章の出現確率を数値化したもので、言語のパターンや意味を表現することができます。言語モデルを作る方法はいくつかありますが、最近ではニューラルネットワークを用いたニューラル言語モデルが主流です。

ニューラル言語モデルは、大量のテキストデータから単語や文章の特徴を学習し、数値ベクトルとして表現します。この数値ベクトルは単語埋め込みや文書埋め込みと呼ばれ、単語や文章の意味や関係性を表すことができます。ニューラル言語モデルは、このようにして得られた数値ベクトルを入力として、次に出現する単語や文章を予測したり、翻訳したり、要約したりすることができます。

ニューラル言語モデルの代表例

ニューラル言語モデルの代表的なものには、以下のようなものがあります。

- Word2Vec:単語埋め込みを獲得するために提案された手法で、周辺の単語から中心の単語を予測するCBOWモデルと、中心の単語から周辺の単語を予測するSkip-gramモデルがあります。

- GloVe:Word2Vecと同じく単語埋め込みを獲得する手法ですが、共起行列を用いたカウントベースの手法と推論ベースの手法を組み合わせています。

- Doc2Vec:Word2Vecを拡張して文書埋め込みを獲得する手法で、入力に文書IDを追加することで文書全体の特徴も学習します。

- Attention:Encoder-Decoderモデルにおいて、入力と出力の対応関係を重み付けする機構で、長い文や複雑な文の処理に有効です。

- BERT:Transformerと呼ばれるAttentionベースのニューラルネットワークを用いて、大規模なテキストコーパスから事前学習した言語モデルで、欠けた単語や文章を予測するマスクド言語モデリングや次文予測などのタスクに優れています。

これらのニューラル言語モデルは、それぞれ異なる特徴や利点を持っていますが、共通して言えることは、より多くのテキストデータからより深いニューラルネットワークで学習することで、より高い性能を発揮するということです。しかし、その反面、学習には多くの計算資源や時間が必要になります。また、学習した言語モデルがどのように言語の意味や構造を捉えているかは、人間にとってはブラックボックスであるという問題もあります。

深層学習とは何か?CNNやRNN、GANやTransformerなどの種類と活用事例を徹底解説!詳しくはこちら

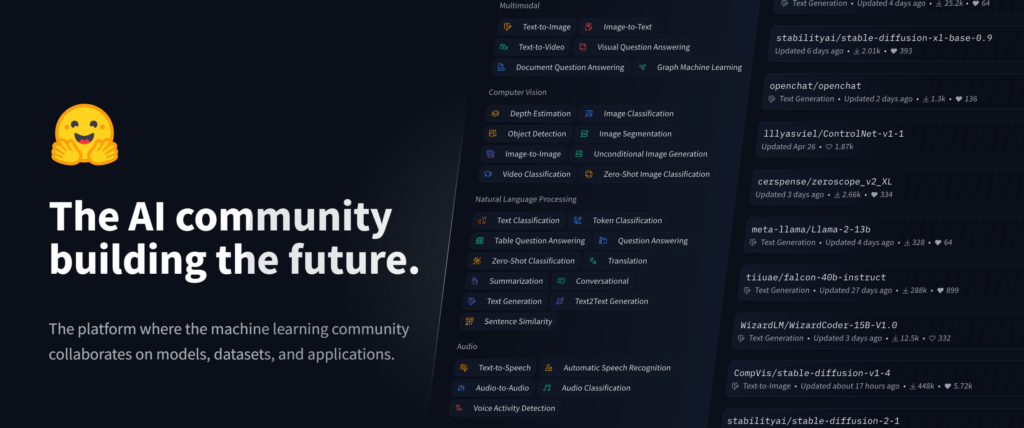

モデルプラットフォーム・hugging faceとは

hugging faceは、NLPの分野で有名なオープンソースのプラットフォームで、多数の事前学習済みの言語モデルやデータセット、アプリケーションなどを提供しています1。hugging faceでは、上記で紹介したWord2VecやBERTなどの言語モデルだけでなく、最新の研究成果やコミュニティの貢献による多様な言語モデルを見つけることができます。また、hugging faceは、PythonやJavaScriptなどの言語で使えるライブラリやAPIも提供しており、簡単に言語モデルを利用したNLPのタスクを実行することができます。

hugging faceの言語モデルへのアクセス方法は、主に以下の2つがあります。

- Webサイトから探す:hugging faceのWebサイトでは、言語モデルやデータセット、アプリケーションなどを検索したり、詳細な情報やドキュメントを見たりすることができます。また、言語モデルの性能や評価を確認したり、自分のテキストを入力して言語モデルの出力を見たりすることもできます。Webサイトから言語モデルをダウンロードすることも可能です。

- ライブラリやAPIから利用する:hugging faceは、PythonやJavaScriptなどの言語で使えるライブラリやAPIも提供しています。これらを利用すると、コード上で簡単に言語モデルをロードしたり、NLPのタスクを実行したりすることができます。例えば、Pythonでは、transformersというライブラリをインストールして、以下のようなコードでBERTの言語モデルを利用できます。

# transformersライブラリをインポート

from transformers import AutoTokenizer, AutoModelForMaskedLM

# BERTのトークナイザーとモデルをロード

tokenizer = AutoTokenizer.from_pretrained("bert-base-uncased")

model = AutoModelForMaskedLM.from_pretrained("bert-base-uncased")

# マスクされた単語を予測する関数を定義

def predict_masked_word(text):

# テキストをトークン化してテンソルに変換

input_ids = tokenizer.encode(text, return_tensors="pt")

# マスクされた単語のインデックスを取得

mask_index = input_ids[0].tolist().index(tokenizer.mask_token_id)

# モデルに入力して出力を取得

output = model(input_ids)

# 出力からマスクされた単語の予測候補を取得

predictions = output.logits[0, mask_index].topk(5).indices

# 予測候補を単語に変換してリストに格納

predicted_words = []

for prediction in predictions:

predicted_word = tokenizer.decode([prediction])

predicted_words.append(predicted_word)

# 予測候補のリストを返す

return predicted_words

# テキストにマスクを入れる

text = "I like to eat [MASK] in the morning."

# マスクされた単語を予測する

predicted_words = predict_masked_word(text)

# 結果を表示する

print(f"Input: {text}")

print(f"Predicted words: {predicted_words}")このように、hugging faceの言語モデルへのアクセス方法は、Webサイトから探す方法とライブラリやAPIから利用する方法があります。どちらの方法も、簡単に言語モデルを見つけたり、試したり、活用したりすることができます。hugging faceは、NLPの分野で最先端の技術やコミュニティを提供しており、NLPに興味のある方にとっては、非常に有用なプラットフォームです。ぜひ活用してAIエンジニアやデータサイエンティストのようなスキルを身に着けてください。

データサイエンティストって何?仕事内容・年収・資格・将来性を徹底解説!詳しくはこちら

まとめ

NLPは、人間の言語をコンピュータに理解させるという難しい課題に挑んでいますが、ニューラル言語モデルの発展によって、その可能性は広がっています。今後もNLPの技術は進化し続け、人間とコンピュータのコミュニケーションをよりスムーズにしてくれるでしょう。

コメント